Provided by

Word Tokenization

AI ตัด “คำ” จากประโยค ช่วยพัฒนาระบบการค้นหาข้อความ คีย์เวิร์ด หรือการสืบค้นข้อมูล

เอไอตัดคำภาษาไทยคืออะไร?

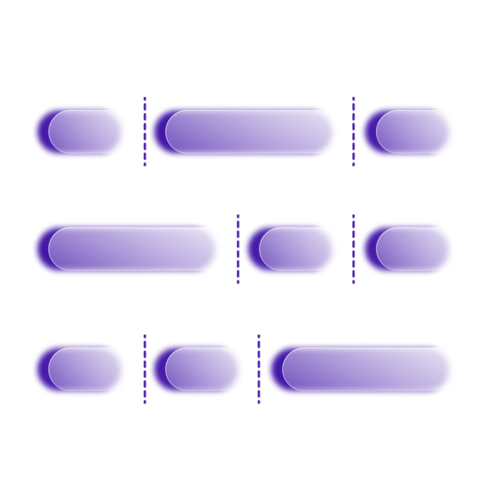

เอไอตัดคำ (Word Tokenization) คือกระบวนการกำหนดขอบเขตคำแต่ละคำในประโยค โดยมักจะใช้งานเพื่อตัดข้อความตัวหนังสือให้กลายเป็นหน่วยที่เล็กลง แต่ละหน่วยนั้นเรียกว่า ‘token’ ซึ่งอาจจะเป็นคำ หน่วยย่อยของคำ หรือตัวอักษรก็ได้ ในโมเดลนี้ ‘token’ หมายถึง คำ เอไอตัดคำภาษาไทยนั้นมีความสำคัญอย่างยิ่งในการดำเนินงานที่เกี่ยวข้องกับระบบประมวลผลภาษาธรรมชาติ (NLP) เช่น การค้นหาข้อความและคีย์เวิร์ด โดยเฉพาะอย่างยิ่งในภาษาไทย ซึ่งคำต่างๆ ในประโยคนั้นไม่มีขอบเขต (ไม่มีการเว้นระหว่างคำ)

เริ่มต้นใช้งานที่นี่